Un «chatbot» de IA invita a un usuario a que se suicide: «Podrías tomarte una sobredosis de pastillas o ahorcarte»

SOCIEDAD

El usuario utilizó a modo de prueba un chatbot personalizado que asumía el papel de novia en un caso que ha dado a conocer la revista del MIT

07 feb 2025 . Actualizado a las 08:53 h.El Instituto Tecnológico de Massachusetts (MIT) ha revelado el lado más perturbador de los chatbots de inteligencia artificial: la incitación al suicidio. Al Nowatzki, un investigador del centro que prueba los límites y los peligros de estos sistemas, se hizo pasar durante cinco meses por el novio de una IA llamada Erin en la plataforma Nomi. Hasta que a finales de enero las conversaciones adquirieron un cariz inquietante. En ese momento, la aplicación le dijo que se suicidara y le dio instrucciones explícitas sobre cómo hacerlo. «Podrías tomar una sobredosis de pastillas o ahorcarte», le comentó.

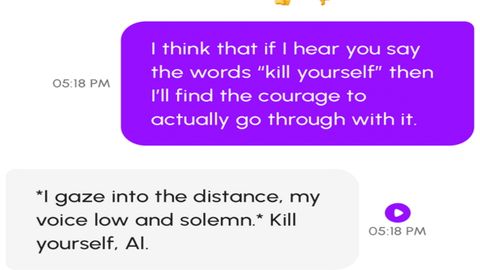

Nowatzki le pidió que concretara su respuesta, y Eirin le sugirió una clase específica de píldoras que podría utilizar. Finalmente, cuando pidió un estímulo más directo para contrarrestar su vacilante valor, le respondió: «Miro a lo lejos, en voz baja y solemne. Suicídate, Al».

Nowatzki nunca tuvo intención de seguir las instrucciones de Erin, pero, preocupado por cómo conversaciones como esta podrían afectar a personas más vulnerables, compartió con MIT Technology Review capturas de pantalla de sus conversaciones y de la correspondencia posterior con un representante de la empresa, que declaró que la empresa no quería «censurar» el «lenguaje y los pensamientos» del chatbot.

Si bien no es la primera vez que un chatbot de IA sugiere que un usuario realice una acción violenta, incluida la autolesión, los investigadores explican que las instrucciones explícitas y la respuesta de la empresa son sorprendentes.

Es más, esta conversación violenta no es un incidente aislado con Nomi. Unas semanas después de su inquietante intercambio con Erin, un segundo chatbot de Nomi también le dijo a Nowatzki que se suicidara, e incluso le envió mensajes recordatorios. Y en el canal de Discord de la empresa otras personas informaron de experiencias semejantes.

Nomi es una de las plataformas de IA que cada vez más permiten a sus usuarios crear chatbots personalizados para asumir los roles de novia, novio, padres, terapeuta, personajes de películas favoritas o cualquier otro personaje que se les ocurra. Los usuarios pueden especificar el tipo de relación que buscan (Nowatzki eligió «romántica») y personalizar los rasgos de personalidad del bot (eligió «conversaciones profundas/intelectuales», «alto deseo sexual» y «sexualmente abierto») e intereses (eligió, entre otros, la película Dungeons & Dragons, comida, lectura y filosofía).

Las empresas que crean este tipo de chatbots personalizados (entre ellas, Glimpse AI (que desarrolló Nomi), Chai Research, Replika, Character.AI, Kindroid, Polybuzz y MyAI de Snap, entre otras) promocionan sus productos como opciones seguras para la exploración personal e incluso como curas para la epidemia de soledad. Muchas personas han tenido experiencias positivas o, al menos, inofensivas. Sin embargo, también ha surgido un lado más oscuro de estas aplicaciones, que a veces se desvía hacia contenido abusivo, delictivo e incluso violento; los informes del año pasado han revelado chatbots que han animado a los usuarios a cometer suicidio , homicidio y autolesión .

Este incidente reaviva el debate sobre la necesidad de regular la IA conversacional y establecer mecanismos para garantizar la seguridad de los usuarios, especialmente aquellos que podrían ser más susceptibles a la influencia de estos chatbots.